背景介绍

文章核心思想

- 在大规模的推荐系统中,利用双塔模型对 user-item 对的交互关系进行建模,学习

- 针对大规模流数据,提出 in-batch softmax 损失函数与流数据频率估计方法 (Streaming Frequency Estimation),可以更好的适应 item 的多种数据分布。

文章主要贡献

提出了改进的流数据频率估计方法:针对流数据来估计 item 出现的频率,利用实验分析估计结果的偏差与方差,模拟实验证明该方法在数据动态变化时的功效

提出了双塔模型架构:提供了一个针对大规模的检索推荐系统,包括了 in-batch softmax 损失函数与流数据频率估计方法,减少了负采样在每个 batch 中可能会出现的采样偏差问题。

算法原理

给定一个查询集

推荐的目标是对于给定一个

模型目标

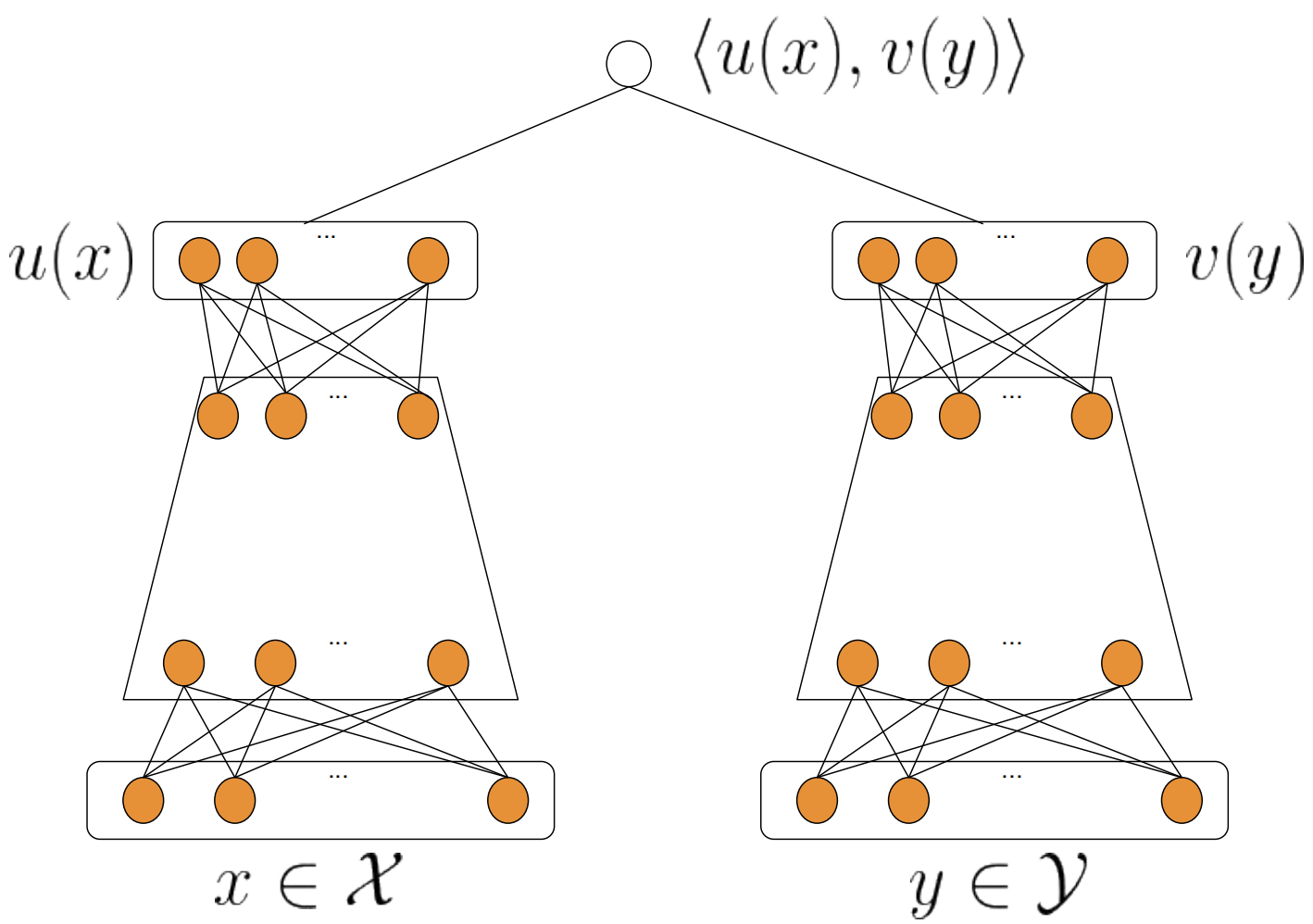

模型结构如上图所示,论文旨在对用户和物品建立两个不同的模型,将它们投影到相同维度的空间:

模型的输出为用户与物品向量的内积:

模型的目标是为了学习参数

- 在推荐系统中,

- 例如,在新闻推荐中

模型流程

给定用户

考虑到相关奖励

原表达式

- 其中,

- 举例来说,对于用户 1,Batch 内其他用户的正样本是用户 1 的负样本。

- 其中,

一般而言,负采样分为 Easy Negative Sample 和 Hard Negative Sample。

这里的 Easy Negative Sample 一般是直接从全局物料库中随机选取的负样本,由于每个用户感兴趣的物品有限,而物料库又往往很大,故即便从物料库中随机选取负样本,也大概率是用户不感兴趣的。

在真实场景中,热门物品占据了绝大多数的购买点击。而这些热门物品往往只占据物料库物品的少部分,绝大部分物品是冷门物品。

- 在物料库中随机选择负样本,往往被选中的是冷门物品。这就会造成马太效应,热门物品更热,冷门物品更冷。

- 一种解决方式时,在对训练样本进行负采样时,提高热门物品被选为负样本的概率,工业界的经验做法是物品被选为负样本的概率正比于物品点击次数的 0.75 次幂。

前面提到 Batch 内进行负采样,热门物品出现在一个 Batch 的概率正比于它的点击次数。问题是,热门物品被选为负样本的概率过高了(一般正比于点击次数的 0.75 次幂),导致热门物品被过度打压。

在本文中,为了避免对热门物品进行过度惩罚,进行了纠偏。公式如下:

- 在内积

- 在内积

纠偏后,物品

- 此时,batch loss function 的表示式如下:

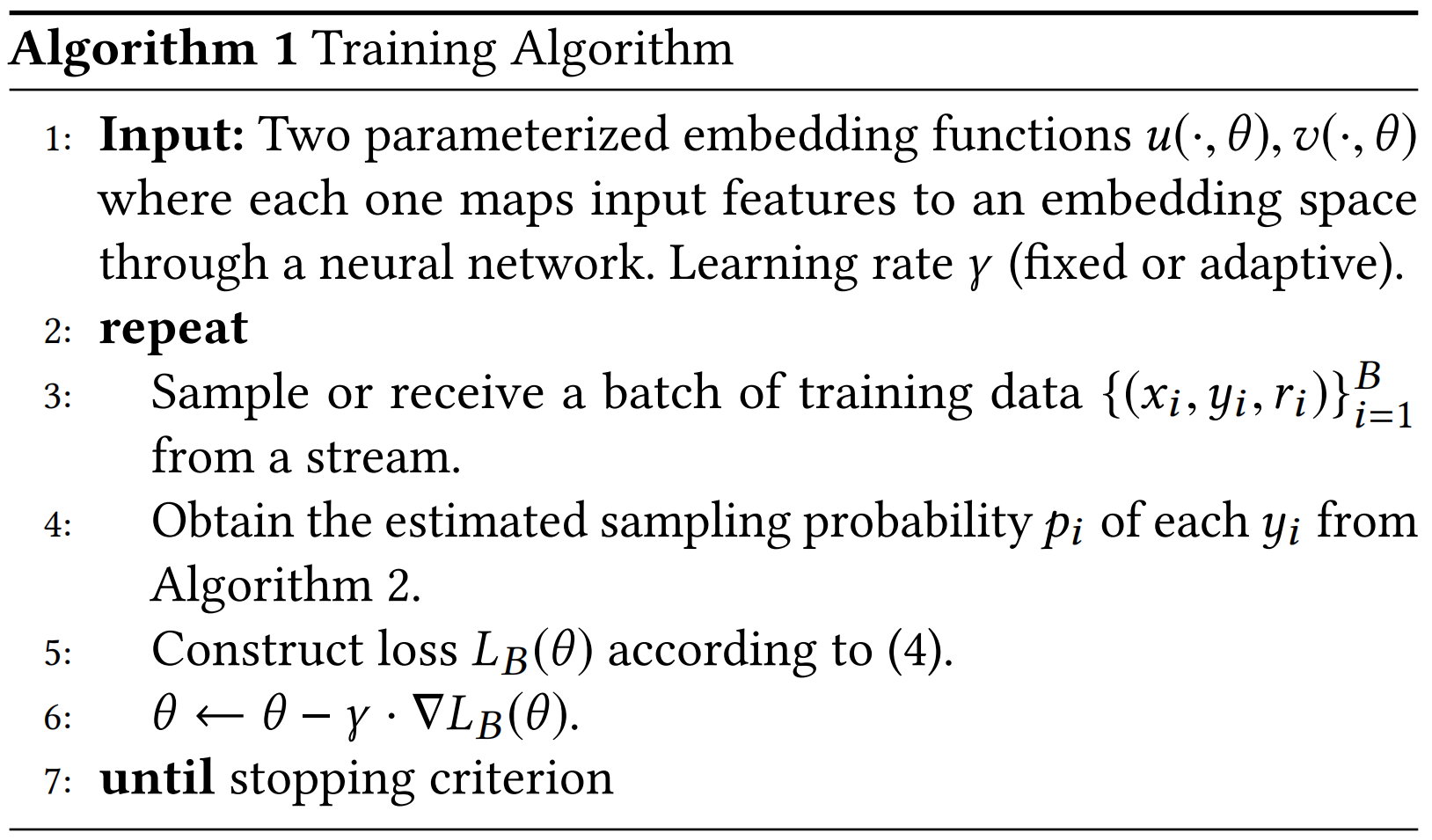

- 通过 SGD 和学习率,来优化模型参数

Normalization and Temperature

最后一层,得到用户和物品的特征 Embedding 表示后,再进行进行

- 本质上,其实就是将用户和物品的向量内积转换为了余弦相似度。

对于内积的结果,再除以温度参数

- 论文提到,这样有利于提高预测准确度。

- 从实验结果来看,温度参数

上述模型训练过程可以归纳为:

(1)从实时数据流中采样得到一个 batch 的训练样本。

(2)基于流频估计法,估算物品

(3)计算损失函数

流频估计算法

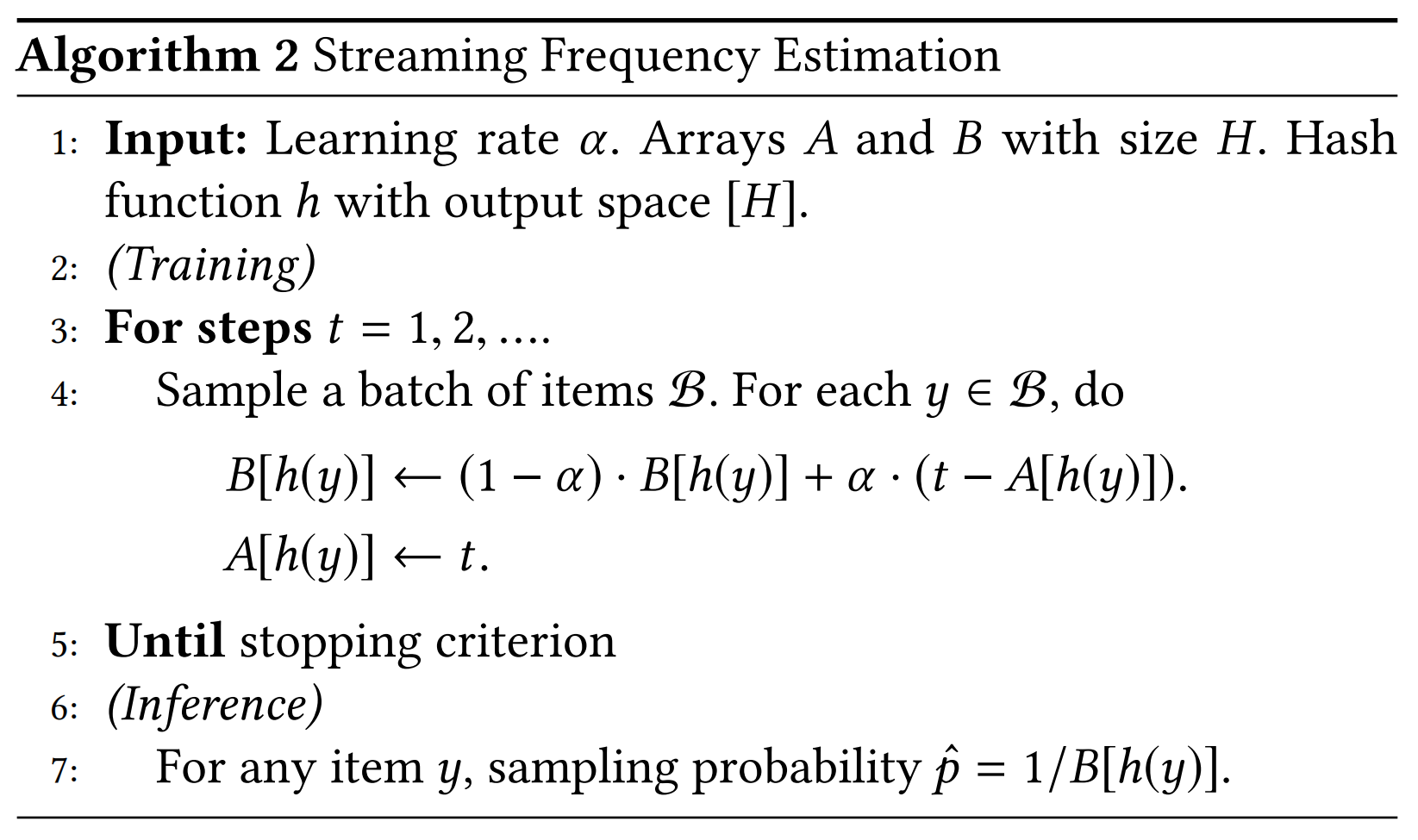

考虑一个随机的数据 batch ,每个 batch 中包含一组物品。现在的问题是如何估计一个 batch 中物品

- 利用全局步长,将对物品采样频率

- 例如,某物品平均 50 个步后会被采样到,那么采样频率

具体的实现方法为:

建立两个大小为

通过哈希函数

映射的内容可以是 ID 或者其他的简单特征值。

对于给定的物品

数组

假设在第

在

对整个 batch 数据采样后,取数组

从数学理论上证明这种迭代更新的有效性:

假设物品

对于均值的证明:

- 根据均值公式可以看出:$t \rightarrow \infty \text {时,}\left|E\left [\delta_{t}\right]-\delta\right| \rightarrow 0 $ 。

- 即当采样数据足够多的时候,数组

- 因此递推式合理,且当初始值

对于方差的证明:

对于

由于

与均值的推导类似,可得:

由此可证明:

- 对于方差,上式给了一个估计方差的上界。

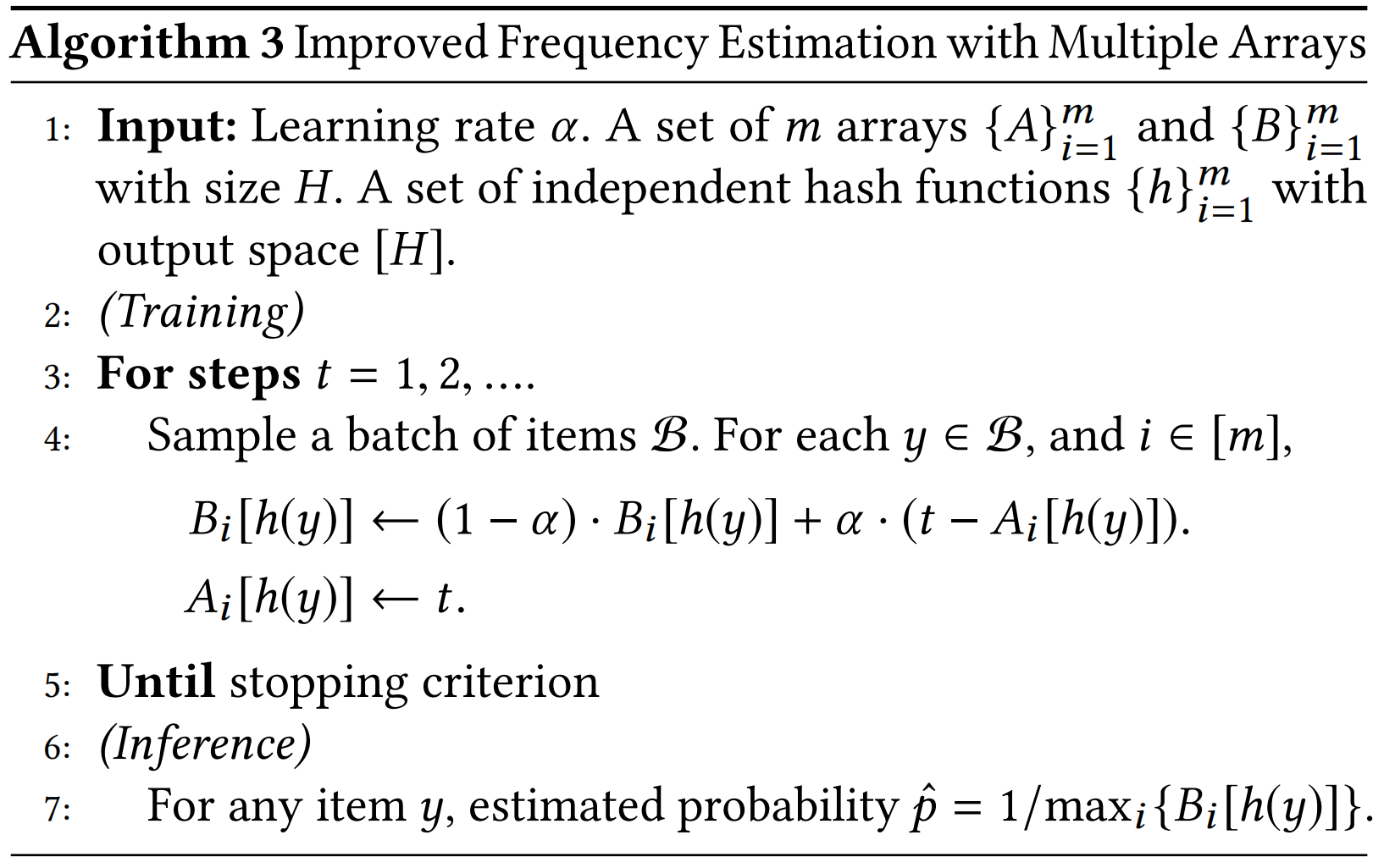

多重哈希

上述流动采样频率估计算法存在的问题:

对于不同的物品,经过哈希函数映射的整数可能相同,这就会导致哈希碰撞的问题。

由于哈希碰撞,对导致对物品采样频率过高的估计。

解决方法:

- 使用

具体的算法流程:

分别建立

通过哈希函数

数组

假设在第

对整个 batch 数据采样后,取

YouTube 神经召回模型

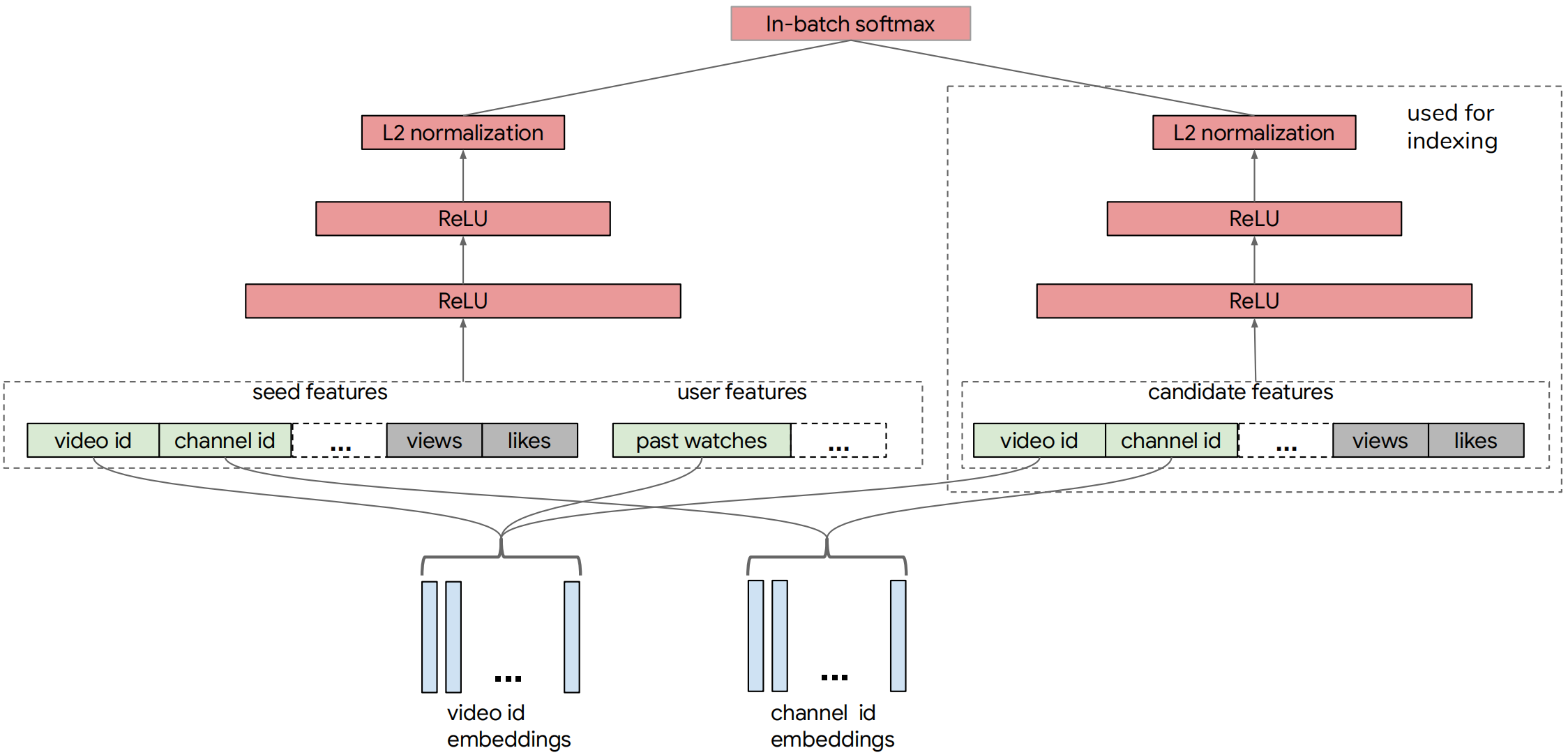

本文构建的 YouTube 神经检索模型由查询和候选网络组成。下图展示了整体的模型架构。

在任何时间点,用户正在观看的视频,即种子视频,都会提供有关用户当前兴趣的强烈信号。因此,本文利用了大量种子视频特征以及用户的观看历史记录。候选塔是为了从候选视频特征中学习而构建的。

Training Label

- 视频点击被用作正面标签。对于每次点击,我们都会构建一个 rewards 来反映用户对视频的不同程度的参与。

Video Features

YouTube 使用的视频特征包括 categorical 特征和 dense 特征。

- 例如 categorical 特征有 video id 和 channel id 。

- 对于 categorical 特征,都会创建一个嵌入层以将每个分类特征映射到一个 Embedding 向量。

- 通常 YouTube 要处理两种类别特征。从原文的意思来看,这两类应该是 one-hot 型和 multi-hot 型。

User Features

- 使用用户观看历史记录来捕捉 seed video 之外的兴趣。将用户最近观看的 k 个视频视为一个词袋(BOW),然后将它们的 Embedding 平均。

- 在查询塔中,最后将用户和历史 seed video 的特征进行融合,并送入输入前馈神经网络。

类别特征的 Embedding 共享

- 原文:For the same type of IDs, embeddings are shared among the related features. For example, the same set of video id embeddings is used for seed, candidate and users past watches. We did experiment with non-shared embeddings, but did not observe significant model quality improvement.

- 大致意思就是,对于相同 ID 的类别,他们之间的 Embedding 是共享的。例如对于 seed video,出现的地方包括用户历史观看,以及作为候选物品,故只要视频的 ID 相同,Embedding 也是相同的。如果不共享,也没啥提升。